源码参考:Muduo

第二部分:Muduo网络库

10. 初探EventLoop

10.1 什么都不做的EventLoop

一个EventLoop就是一个事件循环,下面将通过一个"什么都不做的EventLoop"来大致描述下muduo中EventLoop的功能。

“什么都不做的EventLoop"有如下几个特点:

- one loop per thread意思是说每个线程最多只能有一个EventLoop对象。

- EventLoop对象构造的时候,会检查当前线程是否已经创建了其他EventLoop对象,如果已创建,终止程序(LOG_FATAL)

- EventLoop构造函数会记住本对象所属线程(threadId_)。

- 创建了EventLoop对象的线程称为IO线程,其功能是运行事件循环(EventLoop::loop)

10.2 one loop per thread

这里指的是一个EventLoop只属于一个线程(但一个线程可以拥有多个EventLoop),在muduo中,如果EventLoop一旦被创建,EventLoop会保持所属线程的一份tid拷贝,作为标识。如果该EventLoop被其他线程调用则会报错,muduo中使用EventLoop::assertInLoopThread()函数来判断该EventLoop对象是否是在所属线程中执行。

10.3 事件循环

一个EventLoop里其实是调用了poll/epoll来跟踪所关注的文件描述符的,当有文件描述符上有事件发生时,EventLoop会得到那些发生事件的文件描述符信息。

11. Channel

Channel,可以理解为是一个"通道”,该"通道"中绑定了一个文件描述符及其所关注事件、注册的读写事件等信息。

11.1 Channel与文件描述符

一个Channel管理一个文件描述符,在创建Channel时需要指定:

1

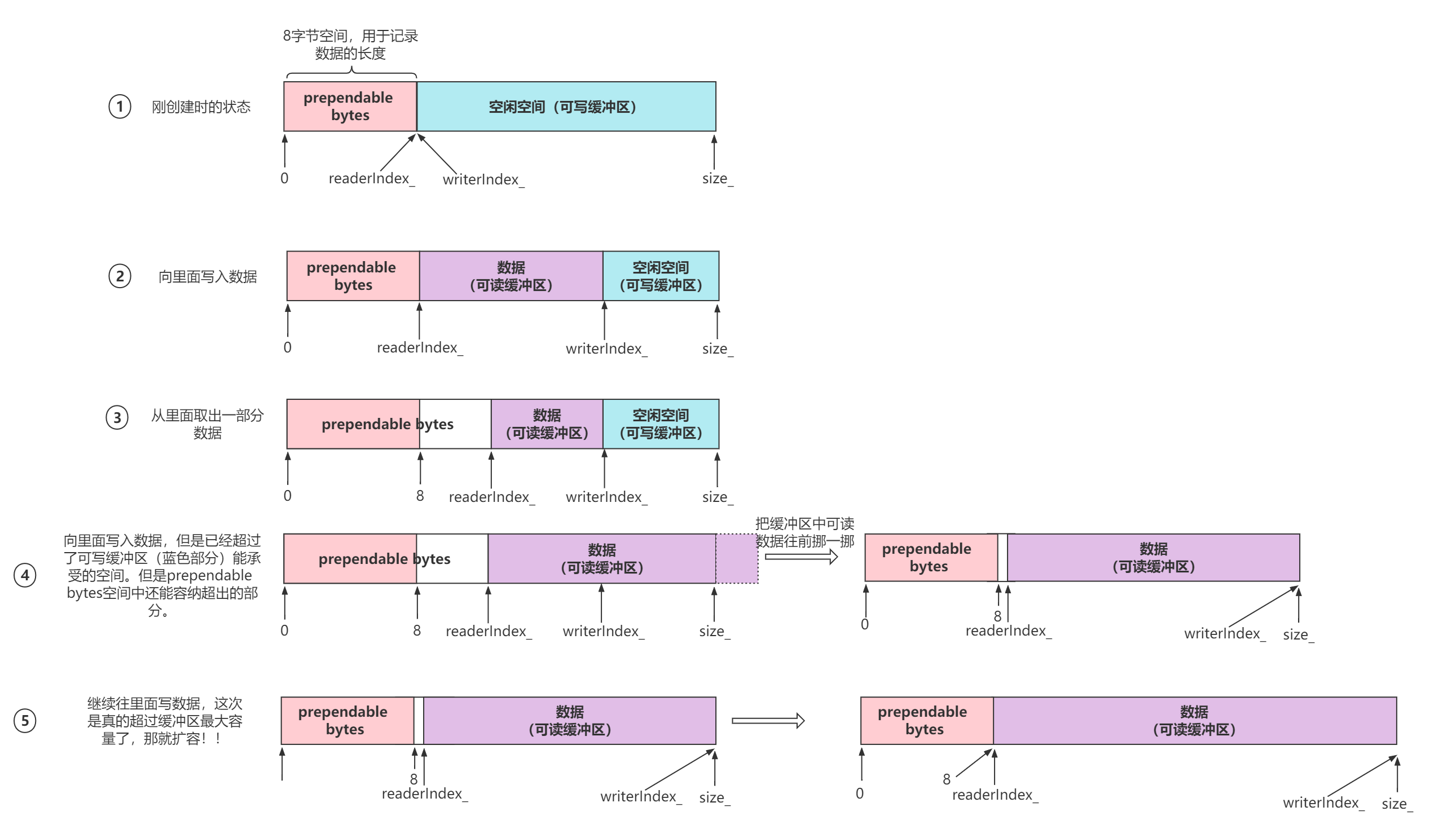

2

3

4

5

6

|

Channel::Channel(EventLoop* loop, int fd__)

: loop_(loop),

fd_(fd__),

... {

}

|

该文件描述符的关注事件可以用如下代码表示:

1

2

3

|

const int Channel::kNoneEvent = 0; //没有事件:0

const int Channel::kReadEvent = POLLIN | POLLPRI; //可读事件:3

const int Channel::kWriteEvent = POLLOUT; //可写事件:4

|

这些宏定义在poll.h头文件中:

1

2

3

4

5

6

|

/* Event types that can be polled for. These bits may be set in `events'

to indicate the interesting event types; they will appear in `revents'

to indicate the status of the file descriptor. */

#define POLLIN 0x001 /* There is data to read. */

#define POLLPRI 0x002 /* There is urgent data to read. */

#define POLLOUT 0x004 /* Writing now will not block. */

|

在Channel内部也定义了events_和revents_来标记文件描述符所关注的事件以及实际发生的事件,该方法和struct pollfd 结构体类似:

1

2

|

int events_; // 关注的事件

int revents_; // poll/epoll返回的事件,即实际监听到发生的事件类型

|

muduo提供了下面这些函数来设置文件描述符关注事件:

1

2

3

4

|

void enableReading() { events_ |= kReadEvent; update(); }

void enableWriting() { events_ |= kWriteEvent; update(); }

void disableWriting() { events_ &= ~kWriteEvent; update(); }

void disableAll() { events_ = kNoneEvent; update(); }

|

其中update函数的作用就是将该Channel及其绑定的文件描述符和EventLoop中的poll/epoll关联起来。

muduo也提供了下面函数来获取和设置文件描述符及其事件的状态,其中需要注意的是set_revents函数,该函数是被poll/epoll类中调用的:

1

2

3

4

5

|

int fd() const { return fd_; }

int events() const { return events_; }

void set_revents(int revt) { revents_ = revt; } // used by pollers

// int revents() const { return revents_; }

bool isNoneEvent() const { return events_ == kNoneEvent; }

|

11.2 设置监听回调函数

Channel中可以设置读、写、错误和关闭事件的回调函数,通过函数模板的方式:

1

2

3

4

5

6

7

8

9

10

11

12

|

typedef boost::function<void()> EventCallback;

typedef boost::function<void(Timestamp)> ReadEventCallback;

ReadEventCallback readCallback_;

EventCallback writeCallback_;

EventCallback closeCallback_;

EventCallback errorCallback_;

void setReadCallback(const ReadEventCallback &cb) { readCallback_ = cb; }

void setWriteCallback(const EventCallback &cb) { writeCallback_ = cb; }

void setCloseCallback(const EventCallback &cb) { closeCallback_ = cb; }

void setErrorCallback(const EventCallback &cb) { errorCallback_ = cb; }

|

11.3 Channel与EventLoop关系

一个Channel一定会关联一个EventLoop,和文件描述符一样,在构造函数中需要传入。一旦关联该EventLoop,EventLoop就可对该Channel操作。

11.4 响应事件

muduo中定义了该函数来响应Channel所绑定的文件描述符发生事件及其回调函数:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

|

//处理绑定的事件

void Channel::handleEvent(Timestamp receiveTime) {

boost::shared_ptr<void> guard;

if (tied_) {

guard = tie_.lock(); //确定shared_ptr指针还存在

if (guard) {

handleEventWithGuard(receiveTime);

}

} else {

handleEventWithGuard(receiveTime);

}

}

/**

* poll函数的事件标志符值:

* 常量 说明

POLLIN 普通或优先级带数据可读

POLLRDNORM 普通数据可读

POLLRDBAND 优先级带数据可读

POLLPRI 高优先级数据可读

POLLOUT 普通数据可写

POLLWRNORM 普通数据可写

POLLWRBAND 优先级带数据可写

POLLERR 发生错误

POLLHUP 对方描述符挂起

POLLNVAL 描述字不是一个打开的文件

*

*/

//开始选择性处理Channel对象绑定的事件

void Channel::handleEventWithGuard(Timestamp receiveTime) {

eventHandling_ = true; //处于处理事件中

// close

if ((revents_ & POLLHUP) && !(revents_ & POLLIN)) {

if (logHup_) {

LOG_WARN << "Channel::handle_event() POLLHUP";

}

//符合关闭套接字的事件,回调close函数

if (closeCallback_)

closeCallback_();

}

//Invalid polling request.

if (revents_ & POLLNVAL) {

LOG_WARN << "Channel::handle_event() POLLNVAL";

}

// error

if (revents_ & (POLLERR | POLLNVAL)) {

if (errorCallback_)

errorCallback_();

}

// read

if (revents_ & (POLLIN | POLLPRI | POLLRDHUP)) {

if (readCallback_)

readCallback_(receiveTime);

}

// write

if (revents_ & POLLOUT) {

if (writeCallback_)

writeCallback_();

}

eventHandling_ = false; //事件已处理完成

}

|

该函数会根据revents_判断该文件描述符上实际发生的事件类型,然后调用相关的注册的回调函数。例如如果是有POLLIN(读事件)产生,那么将调用readCallback_回调函数。

那么什么时候handleEvent函数会执行呢,在poll/epoll返回时,EventLoop对象在loop循环中会拿到有事件发生的Channel集合,并逐一执行它们的handleEvent函数。

12. Poller

12.1 Poller

Poller是一个抽象类,指的是muduo封装的PollPoller、EPollPoller及其父类Poller的总称。在muduo中定义了一个Poller类,该类中定义了一些PollPoller和EPollPoller必须要实现的函数:

1

2

3

|

virtual Timestamp poll(int timeoutMs, ChannelList* activeChannels) = 0;

virtual void updateChannel(Channel* channel) = 0;

virtual void removeChannel(Channel* channel) = 0;

|

一个Channel管理一个文件描述符fd的所有信息与操作,但如果要将文件描述符和poll/epoll关联和注册事件监听,Poller也需要关联Channel并提供相关操作的函数。但是由于poll/epoll的poll函数和操作的方法及其数据结构不同,所以这些具体的实现还是要放在PollPoller和EPollPoller中。

muduo提供了两种事件循环的类PollPoller和EPollPoller,同时也提供了该函数来选择使用哪一个:

1

2

3

4

5

6

7

|

Poller *Poller::newDefaultPoller(EventLoop *loop) {

if (::getenv("MUDUO_USE_POLL")) {

return new PollPoller(loop);

} else {

return new EPollPoller(loop);

}

}

|

12.2 Poller分析

12.2.1 PollPoller和EventLoop关系

一个EventLoop关联一个PollPoller,Channel的update会调用EventLoop的update函数,而EventLoop又调用Poller相关的函数。EventLoop之所以能够"事件循环"也是其内部调用Poller的poll函数。

12.2.2 PollPoller和Channel的关系

Channel管理了一个文件描述符,在muduo中,一个Channel可以看作是一个文件描述符的"代表",如果要操作一个文件描述符,则必须是通过该文件描述符对应的Channel。PollPoller需要监听和返回这些文件描述符上注册和实际发生的事件,所以必须提供操作Channel的函数和数据结构。下面这两个数据结构用于保存文件描述符及其Channel:

1

2

3

4

5

|

typedef std::vector<struct pollfd> PollFdList;

typedef std::map<int, Channel*> ChannelMap;

PollFdList pollfds_;

ChannelMap channels_;

|

- pollfds_的作用非常明显,因为poll函数需要一个struct pollfd的数组地址,所以该结构是用于poll函数参数。

- channels_则是用于管理注册的Channel的,key是Channel对应的文件描述符fd,value就是该Channel的地址,使用map数据结构可以很方便地对Channel进行查找和删除。

12.2.3 update 和 remove Channel

1. updateChannel 函数

由于需要更新一个Channel,所以该函数的参数只有Channel的一份指针:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

|

/**

* 主要时将Channel负责的文件描述符(fd)注册到Poller对象中, 或更新Poller对象

*/

void PollPoller::updateChannel(Channel *channel) {

Poller::assertInLoopThread();

LOG_TRACE << "fd = " << channel->fd() << " events = " << channel->events();

if (channel->index() < 0) {

// index < 0说明是一个新的通道

// a new one, add to pollfds_

assert(channels_.find(channel->fd()) == channels_.end());

struct pollfd pfd;

pfd.fd = channel->fd();

pfd.events = static_cast<short>(channel->events());

pfd.revents = 0; // channel->revents()

pollfds_.push_back(pfd);

int idx = static_cast<int>(pollfds_.size()) - 1;

channel->set_index(idx);

channels_[pfd.fd] = channel; //通过文件描述符(fd) 映射 Channel

} else {

// update existing one

//已存在的Channel

assert(channels_.find(channel->fd()) != channels_.end());

assert(channels_[channel->fd()] == channel);

// index的取值必定在channels_.size()内

int idx = channel->index();

assert(0 <= idx && idx < static_cast<int>(pollfds_.size()));

/**

* 更新pollfds_容器的信息(struct pollfd)

*/

struct pollfd &pfd = pollfds_[idx];

// pfd.fd == -1 代表此Chanel不需被Poller::poll检测

assert(pfd.fd == channel->fd() || pfd.fd == -channel->fd() - 1);

pfd.events = static_cast<short>(channel->events());

pfd.revents = 0;

//如果不再关注该Channel中文件描述符事件,则直接将该文件描述符赋值为其相反数减一。

// 将一个通道暂时更改为不关注事件,但不从Poller中移除该通道

if (channel->isNoneEvent()) {

// ignore this pollfd

// 暂时忽略该文件描述符的事件

// 这里pfd.fd 可以直接设置为-1

pfd.fd = -channel->fd() - 1; // 这样子设置是为了removeChannel优化

}

}

}

|

channel->index() < 0分支:

- 当一个Channel创建后默认设置自身的index_为-1,所以对于新创建的Channel如果被更新,那么一定是走

channel->index() < 0分支的。既然该Channel是刚创建并且是第一次和PollPoller关联,那么PollPoller中一定不会存在该Channel的信息,所以使用了该断言。

- 再接下来就是构造一个pollfd结构体并将该结构体的文件信息通过Channel保存起来,供下次poll函数调用。

- 需要注意的是,上面Channel的index_被设置为当前pollfds_的实际长度减一,这也是为了方便快速获取到pollfds_向量中的对应的文件描述符,有了该文件描述又可以很快从channels_中获取到该Channel,这个过程的代价很小,几乎不需要遍历。

接下来分析channel->index() > 0 的情况:

- 发生这种情况也意味着该Channel之前已经注册到该PollPoller中了,但是由于一些原因需要修改该文件描述符的关注事件,对于这种情况的Channel将调用else分支代码。

- 代码中两个assert断言该Channel是否已经和PollPoller关联,如果关联则取出该pollfd数组中的该Channel对应的文件描述符及其结构体,更新该结构体中文件描述符监听事件。如果不再关注该Channel中文件描述符事件,则直接将该文件描述符赋值为其相反数减一。

2. removeChannel 函数

使用该函数之前一般需要调用 updateChannel 函数设置不再关注该Channel对应的文件描述符上的事件。

该函数定义如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

|

void PollPoller::removeChannel(Channel *channel) {

Poller::assertInLoopThread();

LOG_TRACE << "fd = " << channel->fd();

assert(channels_.find(channel->fd()) != channels_.end());

assert(channels_[channel->fd()] == channel);

assert(channel->isNoneEvent());

int idx = channel->index();

assert(0 <= idx && idx < static_cast<int>(pollfds_.size()));

const struct pollfd &pfd = pollfds_[idx];

(void)pfd;

assert(pfd.fd == -channel->fd() - 1 && pfd.events == channel->events());

size_t n = channels_.erase(channel->fd());

assert(n == 1);

(void)n;

if (implicit_cast<size_t>(idx) == pollfds_.size() - 1) {

pollfds_.pop_back();

} else {

// 这里移除的算法复杂度是O(1),将待删除元素与最后一个元素交换再pop_back

int channelAtEnd = pollfds_.back().fd;

iter_swap(pollfds_.begin() + idx, pollfds_.end() - 1);

//不再关注该Channel中文件描述符事件,通过这种方式获取原有的下标(key)位置

if (channelAtEnd < 0) {

channelAtEnd = -channelAtEnd - 1;

}

channels_[channelAtEnd]->set_index(idx);

pollfds_.pop_back();

}

}

|

- 首先三个断言确认该Channel已经和PollPoller关联而且确认该Channel上的文件描述符事件不再关注,然后找到该Channel文件描述符在pollfds_数组中的位置,将该Channel从Channels_中去除,将该文件描述符对应的pollfd从pollfds_数组中去除。

- 从pollfs_数组中去除一个pollfd,Muduo使用了一个技巧,如果要去除的pollfd结构是数组中的最后一个元素,则调用pop_back函数直接弹出,否则将该元素和数组中最后一个元素交换位置,然后弹出最后一个元素,这样保证了pollfds_数组元素是连续的,不存在中间缺失的情况。

12.2.4 poll

poll函数是在EventLoop中调用的,EventLoop希望通过该函数获取到当前的活动Channel(文件描述符上有事件发生)集合,所以会传入一个ChannelList* activeChannels作为poll的参数,该结构是一个vector集合,保存Channel的地址,定义如下:

1

|

typedef std::vector<Channel*> ChannelList;

|

poll函数定义如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

/**

* poll机制与select机制类似,通过管理文件描述符来进行轮询,效率更高,并且处理的连接个数不受内核的限制。

* 通过poll的方式进行轮询,通过Poller::fillActiveChannels得到活跃事件

*/

Timestamp PollPoller::poll(int timeoutMs, ChannelList *activeChannels) {

// XXX pollfds_ shouldn't change

int numEvents = ::poll(&*pollfds_.begin(), pollfds_.size(), timeoutMs);

Timestamp now(Timestamp::now());

if (numEvents > 0) {

LOG_TRACE << numEvents << " events happended";

fillActiveChannels(numEvents, activeChannels);

} else if (numEvents == 0) {

LOG_TRACE << " nothing happended";

} else {

LOG_SYSERR << "PollPoller::poll()";

}

return now;

}

|

- 该函数的第一个参数是超时时间,第二个参数是EventLoop中需要的活动通道集合。该函数的内部也是调用了poll函数,当poll返回时,该函数会获取当前时间戳,作为函数返回值使用。

poll的返回值:

- 如果poll返回为0,则说明poll超时但没有发生任何事件;

- 如果poll为负值,则说明poll系统调用失败;

- 如果poll正常返回一个整数,则说明当前有文件描述符活动,需要获取这些文件描述符对应的Channel,并返回给EventLoop,这里使用了fillActiveChannels来获取这些活跃的通道;

fillActiveChannels函数定义如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

|

/**

* struct pollfd {

int fd; // 用于检测的文件描述符

short events; // 等待的事件类型

short revents; // 实际发生的事件类型

} ;

通过fd 获得发生事件的Chanel集合

**/

void PollPoller::fillActiveChannels(int numEvents,

ChannelList *activeChannels) const {

for (PollFdList::const_iterator pfd = pollfds_.begin();

pfd != pollfds_.end() && numEvents > 0; ++pfd) {

if (pfd->revents > 0) {

--numEvents;

ChannelMap::const_iterator ch = channels_.find(pfd->fd);

assert(ch != channels_.end());

Channel *channel = ch->second;

assert(channel->fd() == pfd->fd);

channel->set_revents(pfd->revents);

// pfd->revents = 0;

activeChannels->push_back(channel);

}

}

}

|

需要注意的是Channel的index_,在PollPoller中,如果index_为-1,则说明该Channel是新的需要加入的通道;如果index_>0,则说明该Channel已经和PollPoller关联了,index_的值用于在pollfds_数组中查找文件描述符对应的pollfd如果index_为其他负值,则说明该文件描述符将不被关注,该Channel也将被移除。

12.3 EPollPoller 分析

12.3.1 EPollPoller和EventLoop关系

一个EventLoop关联一个EPollPoller,Channel的update会调用EventLoop的update函数,而EventLoop又调用Poller相关的函数。EventLoop之所以能够"事件循环"也是其内部调用Poller的poll函数。

12.3.2 EPollPoller和Channel的关系

Channel管理了一个文件描述符,在muduo中,一个Channel可以看作是一个文件描述符的"代表",如果要操作一个文件描述符,则必须是通过该文件描述符对应的Channel。EPollPoller需要监听和返回这些文件描述符上注册和实际发生的事件,所以必须提供操作Channel的函数和数据结构。下面这两个数据结构用于保存文件描述符及其Channel:

1

2

3

4

5

|

typedef std::vector<struct epoll_event> EventList;

typedef std::map<int, Channel*> ChannelMap;

EventList events_;

ChannelMap channels_;

|

EventList events_的作用非常明显,因为epoll函数需要一个struct epoll_event的数组地址,所以该结构是用于epoll_wait函数参数。ChannelMap channels_则是用于管理注册的Channel的,key是Channel对应的文件描述符fd,value就是该Channel的地址,使用map数据结构可以很方便的对Channel进行查找和操作。

12.3.3 update 和 remove Channel

1. updateChannel 函数

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

|

//将Channel加入epoll中管理,updateChannel方法一定是I/O线程调用的

void EPollPoller::updateChannel(Channel *channel) {

Poller::assertInLoopThread();

LOG_TRACE << "fd = " << channel->fd() << " events = " << channel->events();

const int index = channel->index();

if (index == kNew || index == kDeleted) {

// a new one, add with EPOLL_CTL_ADD

int fd = channel->fd();

if (index == kNew) {

assert(channels_.find(fd) == channels_.end());

channels_[fd] = channel;

} else // index == kDeleted

{

//也就是说,当Channel对象的无事件,可以通过index_来标识为删除状态,并不会从channels_容器中移除

assert(channels_.find(fd) != channels_.end());

assert(channels_[fd] == channel);

}

channel->set_index(kAdded); //设置Channel对象为添加状态

update(EPOLL_CTL_ADD, channel); //添加到epoll中监视

} else {

// update existing one with EPOLL_CTL_MOD/DEL

//更新已存在的Channel描述符,修改或删除

int fd = channel->fd();

(void)fd;

assert(channels_.find(fd) != channels_.end());

assert(channels_[fd] == channel);

assert(index == kAdded);

//当Channel对象不绑定事件,那么就从epoll的监视中移除,并设置Channel对象为删除状态

if (channel->isNoneEvent()) {

update(EPOLL_CTL_DEL, channel);

channel->set_index(kDeleted);

} else { //更新epoll中监视的Channel对象的信息

update(EPOLL_CTL_MOD, channel);

}

}

}

|

这个函数的作用和PollPoller函数作用是一样的。当一个Channel的index_为-1时则说明这个Channel并没有和EPollPoller关联,如果index_为2,则说明该通道被取消过关注,如果为1则说明该Channel已经和EPollPoller关联,需要更新相关文件描述符的一些监听事件:

1

2

3

4

5

|

namespace {

const int kNew = -1; //还没有和EPollPoller关联

const int kAdded = 1; //该Channel已经和EPollPoller关联

const int kDeleted = 2; //该通道被取消关注

}

|

如果index_是kNew或者kDeleted,则说明需要将该通道和该EPollPoller关联,设置index_为kAdded,然后调用update函数将该通道和EPollPoller关联:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

//更新Channel对象绑定的事件

void EPollPoller::update(int operation, Channel *channel) {

struct epoll_event event;

bzero(&event, sizeof event);

event.events = channel->events();

event.data.ptr = channel;

int fd = channel->fd();

if (::epoll_ctl(epollfd_, operation, fd, &event) < 0) {

if (operation == EPOLL_CTL_DEL) {

LOG_SYSERR << "epoll_ctl op=" << operation << " fd=" << fd;

} else {

LOG_SYSFATAL << "epoll_ctl op=" << operation << " fd=" << fd;

}

}

}

|

update函数内部也是调用了epoll_ctl函数。需要注意的是,epoll_event里并没有设置文件描述符,而是用了event.data.ptr指针保存了Channel,毕竟Channel中包含的文件描述符信息更加丰富。

如果index_已经是added状态,那么判断该Channel中文件描述符是否被设置为"不关注",如果是的话,直接调用updata函数将该文件描述符移除epoll事件监听,否则更新该文件描述符结构的events监听事件。

2. removeChannel 函数

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

|

// 将Channel对象从channels_容器和epoll监控中移除,此操作必须是I/O线程调用的

void EPollPoller::removeChannel(Channel *channel) {

Poller::assertInLoopThread();

int fd = channel->fd();

LOG_TRACE << "fd = " << fd;

assert(channels_.find(fd) != channels_.end());

assert(channels_[fd] == channel);

assert(channel->isNoneEvent()); //要移除的Channel对象本身一定是无事件的

int index = channel->index();

// 要移除的Channel对象应该就可能处于关联状态、也可能处于被取消关注状态(kDeleted)

assert(index == kAdded || index == kDeleted);

size_t n = channels_.erase(fd);

(void)n;

assert(n == 1);

// 处于关联状态,说明epoll还在监视它

if (index == kAdded) {

update(EPOLL_CTL_DEL, channel);

}

// 重新设置Channel为未被管理的初始状态

channel->set_index(kNew);

}

|

该函数将取消对Channel对应的文件描述的事件监听,然后将该Channel从channels_中删除。

12.3.4 poll

poll函数是在EventLoop中调用的,EventLoop希望通过该函数获取到当前的活动Channel(文件描述符上有事件发生)集合,所以会传入一个ChannelList* activeChannels作为poll的参数,该结构是一个vector集合,保存Channel的地址,定义如下:

1

|

typedef std::vector<Channel*> ChannelList;

|

poll函数定义如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

|

Timestamp EPollPoller::poll(int timeoutMs, ChannelList *activeChannels) {

//活跃的事件数量

int numEvents = ::epoll_wait(epollfd_, &*events_.begin(),

static_cast<int>(events_.size()), timeoutMs);

Timestamp now(Timestamp::now());

if (numEvents > 0) {

LOG_TRACE << numEvents << " events happended";

fillActiveChannels(numEvents, activeChannels);

//活跃的事件数量太多了,扩容,动态调整

if (implicit_cast<size_t>(numEvents) == events_.size()) {

events_.resize(events_.size() * 2);

}

} else if (numEvents == 0) {

LOG_TRACE << " nothing happended";

} else {

// numEvents < 0 的情况

LOG_SYSERR << "EPollPoller::poll()";

}

return now;

}

|

该函数的第一个参数是超时时间,第二个参数是EventLoop中需要的活动通道集合。该函数的内部也是调用了epoll_wait函数,该函数需要一个额外的文件描述符作为epollfd_,该文件描述符在构造函数初始化参数中中已经初始化了。

当epoll_wait返回时,获取当前时间戳,作为EPollPoller::poll函数返回值使用。

- 如果epoll_wait返回为0,则说明epoll_wait超时且没有发生任何事件;

- 如果poll为负值,则说明poll系统调用失败;

- 如果poll正常返回一个整数,则说明当前有文件描述符活动,需要获取这些文件描述符对应的Channel,并返回给EventLoop,这里使用了fillActiveChannels来获取这些活跃的通道,当活跃的文件描述达到events_数组大小时,该数组将会扩容一倍,以满足更多需求,也减少了vector动态扩张的次数。

fillActiveChannels函数定义如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

|

void EPollPoller::fillActiveChannels(int numEvents,

ChannelList *activeChannels) const {

//活跃的事件数量不可能比装所有事件的容器的元素数量多

assert(implicit_cast<size_t>(numEvents) <= events_.size());

for (int i = 0; i < numEvents; ++i) {

Channel *channel = static_cast<Channel *>(events_[i].data.ptr);

// NDEBUG模式

#ifndef NDEBUG

int fd = channel->fd();

ChannelMap::const_iterator it = channels_.find(fd);

assert(it != channels_.end());

assert(it->second == channel);

#endif

channel->set_revents(events_[i].events);

activeChannels->push_back(channel);

}

}

|

需要注意的是EPollPoller的文件描述符epollfd_,由于EPollPoller是采用RAII技法编写的,在构造函数中创建了文件描述符epollfd_,那么在析构函数中也应该关闭epollfd_并释放资源:

1

|

EPollPoller::~EPollPoller() { ::close(epollfd_); }

|

13. 定时器

muduo的定时器由三个类实现,TimerId、Timer、TimerQueue,用户只能看到第一个类,其它两个都是内部实现细节。

13.1 timerfd_*系列定时器

muduo选择了timerfd_*系列作为定时器。

下面这组函数便是操作timerfd的系统调用:

1

2

3

4

5

6

7

|

#include <sys/timerfd.h>

int timerfd_create(int clockid, int flags);

int timerfd_settime(int fd, int flags, const struct itimerspec *new_value, struct itimerspec *old_value);

int timerfd_gettime(int fd, struct itimerspec *curr_value)

|

timerfd_create,它是用来创建一个定时器描述符timerfd

- 第一个参数:clockid指定时间类型,有两个值:

- CLOCK_REALTIME :Systemwide realtime clock. 系统范围内的实时时钟

- CLOCK_MONOTONIC:以固定的速率运行,从不进行调整和复位 ,它不受任何系统time-of-day时钟修改的影响

- 第二个参数:flags可以是0或者O_CLOEXEC/O_NONBLOCK。

- 返回值:timerfd(文件描述符)

timerfd_settime,该函数作用是用来启动或关闭有fd指定的定时器。在讲解该函数前,先理解两个相关结构体:

1

2

3

4

5

6

7

8

9

|

struct timespec {

time_t tv_sec; /* Seconds */

long tv_nsec; /* Nanoseconds */

};

struct itimerspec {

struct timespec it_interval; /* Interval for periodic timer */

struct timespec it_value; /* Initial expiration */

};

|

第二个结构体itimerspec就是timerfd要设置的超时结构体,它的成员it_value表示定时器第一次超时时间,it_interval表示之后的超时时间即每隔多长时间超时

下面正式分析该函数的参数和返回值:

参数:

- fd:timerfd,有timerfd_create函数返回

- flags:1代表设置的是绝对时间;为0代表相对时间

- fnew_value:指定新的超时时间,设定new_value.it_value非零则启动定时器,否则关闭定时器,如果new_value.it_interval为0,则定时器只定时一次,即初始那次,否则之后每隔设定时间超时一次

- old_value:不为null,则返回定时器这次设置之前的超时时间

timerfd_gettime,此函数用于获得定时器距离下次超时还剩下的时间。如果调用时定时器已经到期,并且该定时器处于循环模式(设置超时时间时struct itimerspec::it_interval不为0),那么调用此函数之后定时器重新开始计时。

13.2 Timer 分析

一个定时器会在某一个时刻执行某个任务,而且有可能是"定时执行",所以,一个Timer里封装了该Timer的超时时间(定时时间)、任务的执行周期等信息:

1

2

3

4

5

|

const TimerCallback callback_; //定时执行函数

Timestamp expiration_; // 超时时间

const double interval_; // 执行间隔

const bool repeat_; // 是否重复定时执行任务

const int64_t sequence_; // 序列号,每个Tmier的序列号都不一样

|

其中sequence_是通过对一个静态变量的原子增加来保证独一无二的:

1

|

static AtomicInt64 s_numCreated_;

|

该原子操作会在Timer构造函数初始化列表中完成初始化:

1

2

3

4

5

6

7

8

|

Timer(const TimerCallback& cb, Timestamp when, double interval)

: callback_(cb),

expiration_(when),

interval_(interval),

repeat_(interval > 0.0),

sequence_(s_numCreated_.incrementAndGet()) {

}

|

Timer也提供了一些列函数来操作和获取这些变量值:

1

2

3

4

5

6

7

8

9

10

11

12

|

void run() const { callback_(); }

//触发事件的时间戳

Timestamp expiration() const { return expiration_; }

bool repeat() const { return repeat_; }

int64_t sequence() const { return sequence_; }

void restart(Timestamp now);

static int64_t numCreated() { return s_numCreated_.get(); }

|

如果要重新设置该Timer的超时时间,可以通过下面这个函数:

1

2

3

4

5

6

7

8

9

10

11

12

|

/**

* 如果是重复的累加的,加入累加的时间重新设置到期时间,否则设置为失效时间

*/

void Timer::restart(Timestamp now) {

if (repeat_) {

// 重新计算下一个超时时刻

expiration_ = addTime(now, interval_);

} else {

//设置无效的时间

expiration_ = Timestamp::invalid();

}

}

|

13.3 TimerId 分析

TimerId 中保存了一个Timer,以及该TimerId的序列号,同时将TimerQueue 设置为友元类:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

|

class Timer;

///

/// An opaque identifier, for canceling Timer.

///

class TimerId : public muduo::copyable {

public:

TimerId() : timer_(NULL), sequence_(0) {}

TimerId(Timer *timer, int64_t seq) : timer_(timer), sequence_(seq) {}

// default copy-ctor, dtor and assignment are okay

friend class TimerQueue;

private:

Timer *timer_;

int64_t sequence_;

};

|

13.4 TimerQueue

13.4.1 TimerQueue 设计原理

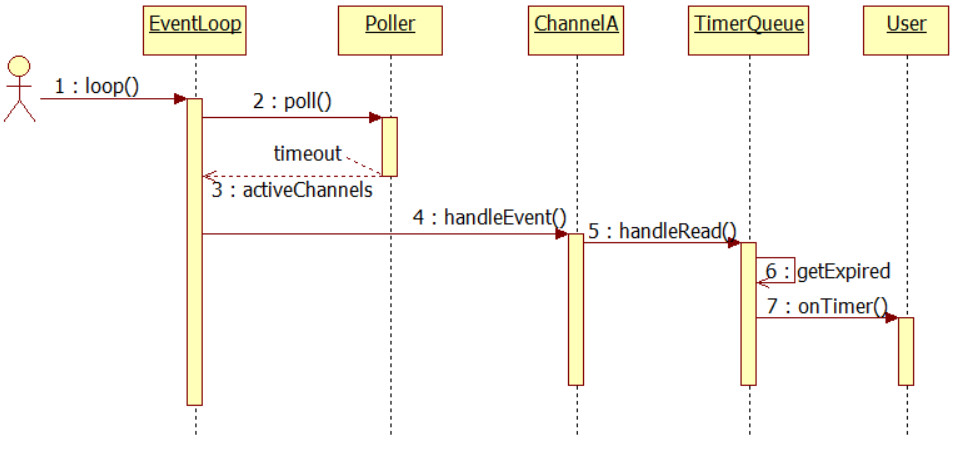

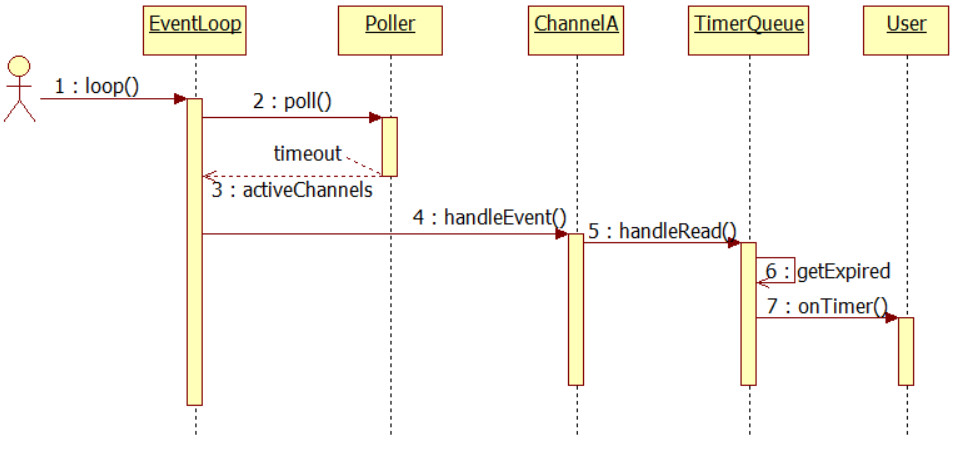

一个TimerQueue 会关联一个EventLoop,一个TimerQueue中会绑定一个文件描述符timerfd以及Channel。该TimerQueue中保存众多的Timer,并且将这些Timer根据其超时时间从小到大放入一个集合中,其中最近超时时间将设置为timerfd的超时时间(也就是说将最近超时时间关联到timerfd上),到了该时间,timerfd上会有读事件发生,然后定时器会将定时在该超时时间到真正处理该读事件之间的Timer获取到,执行这些Timer的定时函数。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

|

// FIXME: use unique_ptr<Timer> instead of raw pointers.

// unique_ptr是C++ 11标准的一个独享所有权的智能指针

// 无法得到指向同一对象的两个unique_ptr指针

// 但可以进行移动构造与移动赋值操作,即所有权可以移动到另一个对象(而非拷贝构造)

typedef std::pair<Timestamp, Timer *> Entry;

typedef std::set<Entry> TimerList;

typedef std::pair<Timer *, int64_t> ActiveTimer;

typedef std::set<ActiveTimer> ActiveTimerSet;

EventLoop *loop_; // 所属EventLoop

const int timerfd_;

Channel timerfdChannel_;

// Timer list sorted by expiration

// set中的元素都是排好序的, 用于存储Timer,同时将Timer的到期时间戳作为key

TimerList timers_; // timers_是按到期时间排序

// for cancel()

// timers_与activeTimers_保存的是相同的数据 =》 利于操作,空间换效率吧???

// timers_是按到期时间排序,activeTimers_是按对象地址排序

ActiveTimerSet activeTimers_;

bool callingExpiredTimers_; //用来确定是否正在调用回调函数的定时器/* atomic */

ActiveTimerSet cancelingTimers_; // 保存的是被取消的定时器

|

TimerQueue 的构造函数如下:

1

2

3

4

5

6

7

8

9

10

11

|

/**

* 一个TimerQueue只对应一个Eventloop和一个内部构造的Channel(构造对象时,默认绑定一个定时器对象timerfd_)

* 同时设置Channel的回调函数TimerQueue::handleRead

*/

TimerQueue::TimerQueue(EventLoop *loop)

: loop_(loop), timerfd_(createTimerfd()), timerfdChannel_(loop, timerfd_),

timers_(), callingExpiredTimers_(false) {

timerfdChannel_.setReadCallback(boost::bind(&TimerQueue::handleRead, this));

// we are always reading the timerfd, we disarm it with timerfd_settime.

timerfdChannel_.enableReading();

}

|

构造函数中使用了createTimerfd来创建一个定时器文件描述符,该函数定义如下:

1

2

3

4

5

6

7

8

9

10

|

/**

* 创建定时器,生成一个定时器对象,返回与之关联的文件描述符timerfd。

*/

int createTimerfd() {

int timerfd = ::timerfd_create(CLOCK_MONOTONIC, TFD_NONBLOCK | TFD_CLOEXEC);

if (timerfd < 0) {

LOG_SYSFATAL << "Failed in timerfd_create";

}

return timerfd;

}

|

构造函数中Channel绑定的"读事件"回调函数是TimerQueue::handleRead,该函数定义如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

|

/**

* I/O线程才可调用

* 用来设置关联的Channel的回调函数

*/

void TimerQueue::handleRead() {

loop_->assertInLoopThread();

Timestamp now(Timestamp::now());

// 清除该事件,避免一直触发,并记录触发TimerQueue::handleRead回调函数的时间

readTimerfd(timerfd_, now);

// 获取该时刻之前所有的定时器列表(即超时定时器列表)

std::vector<Entry> expired = getExpired(now);

callingExpiredTimers_ = true;

cancelingTimers_.clear();

// safe to callback outside critical section

for (std::vector<Entry>::iterator it = expired.begin(); it != expired.end();

++it) {

// 这里回调定时器处理函数

it->second->run();

}

callingExpiredTimers_ = false;

// 不是一次性定时器,需要重启

reset(expired, now);

}

|

如果定时器超时,那么将执行该回调函数,该回调函数会调用readTimerfd函数先处理文件描述符事件,readTimerfd 函数定义如下:

1

2

3

4

5

6

7

8

9

10

11

12

|

// 清除定时器,避免一直触发,并记录传入的时间戳

void readTimerfd(int timerfd, Timestamp now) {

uint64_t howmany;

ssize_t n = ::read(timerfd, &howmany, sizeof howmany);

LOG_TRACE << "TimerQueue::handleRead() " << howmany << " at "

<< now.toString();

if (n != sizeof howmany) {

LOG_ERROR << "TimerQueue::handleRead() reads " << n

<< " bytes instead of 8";

}

}

|

在处理完文件描述符读事件后调用getExpired函数获取从文件描述符事件发生到当前时间内超时的Timer,然后遍历该集合,获取到Timer并执行其run函数(run函数中执行的是Timer真正的定时函数)。处理完这些超时的Timer后调用reset函数来重置这些Timer的定时任务,因为有些Timer是设置为循环执行的,所以还要重新设置它们的下一次执行时间。

13.4.2 向TimerQueue 中添加一个Timer

TimerQueue使用addTimer函数来向队列中添加一个Timer:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

|

/**

* 添加一个新Timer,并及时更新;

* 如果TimerList中元素只有一个或插入的Timer最快到期,马上重新设置TimerQueue对象绑定的timerfd的超时时间

*/

TimerId TimerQueue::addTimer(const TimerCallback &cb, Timestamp when,

double interval) {

/**

* 该对象将存储到TimerList中

* => std::set<std::pair<Timestamp, Timer*>> TimerList;

*/

Timer *timer = new Timer(cb, when, interval);

loop_->runInLoop(boost::bind(&TimerQueue::addTimerInLoop, this, timer));

// addTimerInLoop(timer);

return TimerId(timer, timer->sequence());

}

|

该函数需要传入一个定时回调函数,一个超时时间戳和定时周期,TimerCallback的原型如下所示:

1

|

typedef boost::function<void()> TimerCallback;

|

创建一个Timer,然后通过EventLoop调用TimerQueue::addTimerInLoop函数,最后TimerQueue::addTimer返回一个TimerId。runInLoop的实现细节在后面章节会解释,addTimerInLoop函数的定义如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

|

/**

* I/O线程才可调用

*/

void TimerQueue::addTimerInLoop(Timer *timer) {

loop_->assertInLoopThread();

// 插入一个定时器,有可能会使得最早到期的定时器发生改变

bool earliestChanged = insert(timer);

if (earliestChanged) {

// 重置定时器的超时时刻(timerfd_settime)

resetTimerfd(timerfd_, timer->expiration());

}

}

|

该函数又调用了insert函数,insert定义如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

|

/**

* 返回值,插入的Timer是否是最早到期的时间;说明:插入的Timer元素是有序timers_(set集合)的第一个元素或唯一的元素为true

* 功能:插入一个std::pair<Timestamp,Timer*>对象,将参数timer的到期时间戳作为std::pair的first,Timner对象作为sencond

* activeTimers_ 和 timers_两个容器保存的Timer对象是一样的,仅仅内存分布不同而已

*/

bool TimerQueue::insert(Timer *timer) {

loop_->assertInLoopThread();

assert(timers_.size() == activeTimers_.size());

// 最早到期时间是否改变

bool earliestChanged = false;

Timestamp when = timer->expiration();

TimerList::iterator it = timers_.begin();

// 如果timers_为空或者when小于timers_中的最早到期时间(这个插入的Timer是集合第一个到期的时间戳)

if (it == timers_.end() || when < it->first) {

earliestChanged = true;

}

{

// 插入到timers_中

std::pair<TimerList::iterator, bool> result =

timers_.insert(Entry(when, timer));

// result.first代表插入的元素的iterator,result.second代表元素是否插入成功

assert(result.second);

(void)result;

}

{

// 插入到activeTimers_中

std::pair<ActiveTimerSet::iterator, bool> result =

activeTimers_.insert(ActiveTimer(timer, timer->sequence()));

assert(result.second);

(void)result;

}

assert(timers_.size() == activeTimers_.size());

return earliestChanged;

}

|

insert函数会获取到该Timer的超时时间,如果该Timer的超时时间是最近的(比之前从小到大排列的超时集合最小的还小),说明该Timer的定时函数是最早执行的,所以设置标志earliestChanged = true,然后将该Timer加入到timers_和activeTimers_中,然后返回earliestChanged。

回到TimerQueue::addTimerInLoop函数,该函数在插入一个Timer后,判断earliestChanged,如果该项为true,那么也需要重新设置TimerQueue的timerfd_的定时时间,则调用resetTimerfd函数:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

|

/**

* 重置定时器的超时时间,重新设置Timer文件描述符(Timerfd)的超时时间,启动或停止定时器

*/

void resetTimerfd(int timerfd, Timestamp expiration) {

// wake up loop by timerfd_settime()

struct itimerspec newValue;

struct itimerspec oldValue;

bzero(&newValue, sizeof newValue);

bzero(&oldValue, sizeof oldValue);

newValue.it_value = howMuchTimeFromNow(expiration);

//启动或停止定时器,依据newValue

int ret = ::timerfd_settime(timerfd, 0, &newValue, &oldValue);

if (ret) {

LOG_SYSERR << "timerfd_settime()";

}

}

|

13.4.3 获取超时Timer

getExpired函数会获取到将小于传入时间戳now的Timer,将这些Timer的Entry保存到一个vector中并返回,同时删除timers_和activeTimers_中的这些和Timer相关的部分。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

|

/**

* rvo优化

* 返回一个到期时间std::vector<Entry>的容器

* =》typedef std::pair<Timestamp,Timer*> Entry;

*/

std::vector<TimerQueue::Entry> TimerQueue::getExpired(Timestamp now) {

assert(timers_.size() == activeTimers_.size());

std::vector<Entry> expired;

// std::pair作为set的key时,比较pair 是先比较first, first相同再比较second

Entry sentry(now, reinterpret_cast<Timer *>(UINTPTR_MAX));

// 返回第一个未到期的Timer的迭代器

// lower_bound的含义是返回第一个值>=sentry的元素的iterator

// 即*end >= sentry,从而end->first > now

TimerList::iterator end = timers_.lower_bound(sentry);

// timers_的集合全是过期的时间戳,或者???

assert(end == timers_.end() || now < end->first);

// 将到期的定时器插入到expired中

std::copy(timers_.begin(), end, back_inserter(expired));

// 从timers_中移除到期的定时器

timers_.erase(timers_.begin(), end);

// 从activeTimers_中移除到期的定时器

for (std::vector<Entry>::iterator it = expired.begin(); it != expired.end();

++it) {

ActiveTimer timer(it->second, it->second->sequence());

size_t n = activeTimers_.erase(timer);

assert(n == 1);

(void)n;

}

assert(timers_.size() == activeTimers_.size());

return expired;

}

|

13.4.4 向TimerQueue 中取消一个Timer

muduo使用cancle来取消一个Timer:

1

2

3

|

void TimerQueue::cancel(TimerId timerId) {

loop_->runInLoop(boost::bind(&TimerQueue::cancelInLoop, this, timerId));

}

|

该函数又调用了TimerQueue::cancelInLoop:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

|

/**

* I/O线程才可调用

*/

void TimerQueue::cancelInLoop(TimerId timerId) {

loop_->assertInLoopThread();

assert(timers_.size() == activeTimers_.size());

ActiveTimer timer(timerId.timer_, timerId.sequence_);

// 查找该定时器

ActiveTimerSet::iterator it = activeTimers_.find(timer);

if (it != activeTimers_.end()) {

size_t n = timers_.erase(Entry(it->first->expiration(), it->first));

assert(n == 1);

(void)n;

delete it->first; // FIXME: no delete

// please,如果用了unique_ptr,这里就不需要手动删除了

activeTimers_.erase(it);

} else if (callingExpiredTimers_) {

// 已经到期,并且正在调用回调函数的定时器

cancelingTimers_.insert(timer);

}

assert(timers_.size() == activeTimers_.size());

}

|

该函数以TimerId的方式从TimerQueue中删除相关Timer内容,如果该当前TimerQueue已经有超时事件产生(handleRead中callingExpiredTimers_设置为true),TimerQueue::getExpired会删除超时的Timer,那么还需要将该Timer保存到"待取消定时器队列"中:

1

|

ActiveTimerSet cancelingTimers_;

|

13.4.5 重置超时Timer

handleRead函数:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

|

/**

* I/O线程才可调用

* 用来设置关联的Channel的回调函数

*/

void TimerQueue::handleRead() {

loop_->assertInLoopThread();

Timestamp now(Timestamp::now());

// 清除该事件,避免一直触发,并记录触发TimerQueue::handleRead回调函数的时间

readTimerfd(timerfd_, now);

// 获取该时刻之前所有的定时器列表(即超时定时器列表)

std::vector<Entry> expired = getExpired(now);

callingExpiredTimers_ = true;

cancelingTimers_.clear();

// safe to callback outside critical section

for (std::vector<Entry>::iterator it = expired.begin(); it != expired.end();

++it) {

// 这里回调定时器处理函数

it->second->run();

}

callingExpiredTimers_ = false;

// 不是一次性定时器,需要重启

reset(expired, now);

}

|

如果已经去除队列中的超时定时器集合,这些集合的定时任务也处理完了之后还需要reset这些集合,因为一个定时器Timer可能设置了repeat_和interval_,需要重新设置下一次Timer的执行时间。reset函数定义如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

|

/**

* 对已经过期的队列进行处理,如果是重复调用的,重新设置新的到期时间并加入Timer队列中继续监控;重新设置TimerQueue对象绑定的fd到期时间

*/

void TimerQueue::reset(const std::vector<Entry> &expired, Timestamp now) {

Timestamp nextExpire;

for (std::vector<Entry>::const_iterator it = expired.begin();

it != expired.end(); ++it) {

ActiveTimer timer(it->second, it->second->sequence());

// 如果是重复的定时器并且是未取消定时器,则重启该定时器

if (it->second->repeat() &&

cancelingTimers_.find(timer) == cancelingTimers_.end()) {

//如果是重复的累加的,加入累加的时间重新设置到期时间,否则设置为失效时间

it->second->restart(now);

//将累加后新的Timer插入到Timer队列中,继续监控

insert(it->second);

} else {

// 一次性定时器或者已被取消的定时器是不能重置的,因此删除该定时器

// FIXME move to a free list

delete it->second; // FIXME: no delete please

}

}

if (!timers_.empty()) {

// //得到队列中第一个要到期的时间,获取最早到期的定时器超时时间

nextExpire = timers_.begin()->second->expiration();

}

//队列中还未到期的时间是有效的

if (nextExpire.valid()) {

// 重置定时器的超时时刻(timerfd_settime),重新设置TimerQueue对象绑定的fd到期时间

resetTimerfd(timerfd_, nextExpire);

}

}

|

这个函数会检查这些超时的定时器Timer,如果是设置了repeat_为true并且不在"取消定时器队列"中则重置下一次定时器执行时间,否则(如一次性定时任务,或者取消了但未能避免执行)则直接删除。在执行handleRead时也会将cancelingTimers_清空。最后设置TimerQueue的timerfd_最近定时时间,准备下一次执行定时事件的到来。

13.4.6 析构函数与资源销毁

关闭timerfd_文件描述符,释放管理的所有Timer资源。

1

2

3

4

5

6

7

|

TimerQueue::~TimerQueue() {

::close(timerfd_); //关闭关联的描述符

// do not remove channel, since we're in EventLoop::dtor();

for (TimerList::iterator it = timers_.begin(); it != timers_.end(); ++it) {

delete it->second;

}

}

|

14. 深入 EventLoop

已经分析过一个"什么都不做的EventLoop",muduo中的EventLoop有如下几个特点:

- one loop per thread意思是说每个线程最多只能有一个EventLoop对象。

- EventLoop对象构造的时候,会检查当前线程是否已经创建了其他EventLoop对象,如果已创建,终止程序(LOG_FATAL)

- EventLoop构造函数会记住本对象所属线程(threadId_)。

- 创建了EventLoop对象的线程称为IO线程,其功能是运行事件循环(EventLoop::loop)

下面将深入具体分析muduo中的EventLoop的实现。

14.1 EventLoop 与 Channel

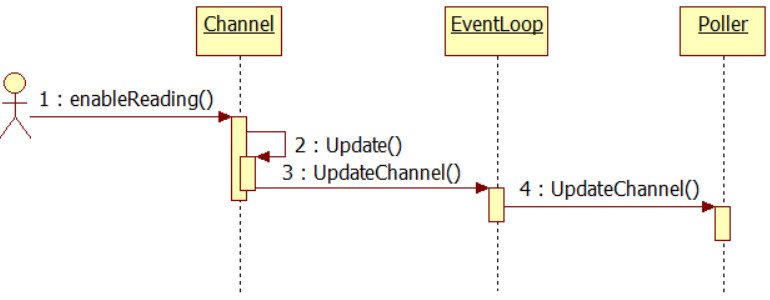

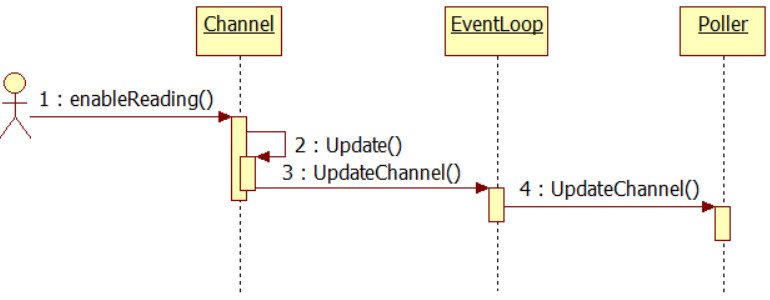

“一个Channel会关联一个EventLoop”,当Channel设置了监听文件描述符关注事件类型后会调用update函数,Channel中的update函数也是间接调用EventLoop的updateChannel函数,然后又间接调用Poller的updateChannel函数,该函数将会将该Channel及其相关文件描述符和Poller的事件监听联系起来。

1

2

3

4

5

6

7

8

|

//将Chanel注册到Poller对象的polldfs数组中

void Channel::update() { loop_->updateChannel(this); }

void EventLoop::updateChannel(Channel *channel) {

assert(channel->ownerLoop() == this);

assertInLoopThread();

poller_->updateChannel(channel);

}

|

同样地,Channel的remove函数也是间接调用EventLoop的removeChannel函数来删除自身,Poller的removeChannel函数会取消该Channel及其文件描述符的事件监听,并不再保存该Channel及其文件描述符任何信息。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

// 调用这个函数之前确保调用disableAll

void Channel::remove() {

assert(isNoneEvent());

loop_->removeChannel(this);

}

void EventLoop::removeChannel(Channel *channel) {

assert(channel->ownerLoop() == this);

assertInLoopThread();

if (eventHandling_) {

assert(currentActiveChannel_ == channel ||

std::find(activeChannels_.begin(), activeChannels_.end(), channel) ==

activeChannels_.end());

}

poller_->removeChannel(channel);

}

|

14.2 EventLoop 与 TimerQueue

EventLoop中持有一个TimerQueue,并在构造函数中完成了该TimerQueue的初始化:

1

2

3

4

5

6

7

8

9

|

boost::scoped_ptr<TimerQueue> timerQueue_;

EventLoop::EventLoop()

: looping_(false),

...

timerQueue_(new TimerQueue(this)),

... {

...

}

|

接下来是一组定时器操作函数,用于添加定时器任务:

EventLoop.h

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

|

///

/// Runs callback at 'time'.

/// Safe to call from other threads.

///

//直接回调

TimerId runAt(const Timestamp &time, const TimerCallback &cb);

///

/// Runs callback after @c delay seconds.

/// Safe to call from other threads.

///

//延期回调

TimerId runAfter(double delay, const TimerCallback &cb);

///

/// Runs callback every @c interval seconds.

/// Safe to call from other threads.

///

//以interval的频率回调

TimerId runEvery(double interval, const TimerCallback &cb);

///

/// Cancels the timer.

/// Safe to call from other threads.

///

void cancel(TimerId timerId);

|

EventLoop.cpp

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

TimerId EventLoop::runAt(const Timestamp &time, const TimerCallback &cb) {

return timerQueue_->addTimer(cb, time, 0.0);

}

TimerId EventLoop::runAfter(double delay, const TimerCallback &cb) {

Timestamp time(addTime(Timestamp::now(), delay));

return runAt(time, cb);

}

TimerId EventLoop::runEvery(double interval, const TimerCallback &cb) {

Timestamp time(addTime(Timestamp::now(), interval));

return timerQueue_->addTimer(cb, time, interval);

}

void EventLoop::cancel(TimerId timerId) { return timerQueue_->cancel(timerId); }

|

本质上这些函数也是调用了TimerQueue的addTimer和cancel函数,需要关注的是addTimer和cancel函数内部都是通过EventLoop::runInLoop函数调用的:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

|

/**

* 添加一个新Timer,并及时更新;

* 如果TimerList中元素只有一个或插入的Timer最快到期,马上重新设置TimerQueue对象绑定的timerfd的超时时间

*/

TimerId TimerQueue::addTimer(const TimerCallback &cb, Timestamp when,

double interval) {

/**

* 该对象将存储到TimerList中

* std::set<std::pair<Timestamp, std::unique_ptr<Timer>>>

*/

Timer *timer = new Timer(cb, when, interval);

loop_->runInLoop(boost::bind(&TimerQueue::addTimerInLoop, this, timer));

// addTimerInLoop(timer);

return TimerId(timer, timer->sequence());

}

void TimerQueue::cancel(TimerId timerId) {

loop_->runInLoop(boost::bind(&TimerQueue::cancelInLoop, this, timerId));

// cancelInLoop(timerId);

}

|

使用EventLoop::runInLoop能够保证该bind函数是在EventLoop所在线程内执行的,哪怕这个函数是在别的线程里被调用,关于EventLoop::runInLoop函数,后面的章节再分析它是如何实现跨线程安全调用的。

14.3 EventLoop 与 Poller

一个EventLoop持有一个poller:

1

2

3

4

5

6

7

8

9

|

boost::scoped_ptr<Poller> poller_;

EventLoop::EventLoop()

: looping_(false),

...

poller_(Poller::newDefaultPoller(this)),

... {

...

}

|

Poller::newDefaultPoller会根据系统环境来选择是使用PollPoller还是EPollPoller:

1

2

3

4

5

6

7

|

Poller *Poller::newDefaultPoller(EventLoop *loop) {

if (::getenv("MUDUO_USE_POLL")) {

return new PollPoller(loop);

} else {

return new EPollPoller(loop);

}

}

|

EventLoop的核心函数loop便是调用了Poller的loop函数:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

|

// 事件循环,该函数不能跨线程调用

// 只能在创建该对象的线程中调用

void EventLoop::loop() {

assert(!looping_);

// 断言当前处于创建该对象的线程中

assertInLoopThread();

looping_ = true;

quit_ = false;

LOG_TRACE << "EventLoop " << this << " start looping";

//::poll(NULL, 0, 5*1000);

while (!quit_) {

activeChannels_.clear();

//执行完Poller::poll()的时间

pollReturnTime_ = poller_->poll(kPollTimeMs, &activeChannels_);

//++iteration_;

if (Logger::logLevel() <= Logger::TRACE) {

printActiveChannels();

}

// TODO sort channel by priority

eventHandling_ = true; //标识事件正在处理

for (ChannelList::iterator it = activeChannels_.begin();

it != activeChannels_.end(); ++it) {

currentActiveChannel_ = *it;

currentActiveChannel_->handleEvent(pollReturnTime_); //事件处理

}

currentActiveChannel_ = NULL;

eventHandling_ = false; //标识事件已处理完成

// 让IO线程也能执行一些计算任务,IO不忙的时候,处于阻塞状态

doPendingFunctors(); // 执行其他线程或者本线程添加的一些回调任务

}

LOG_TRACE << "EventLoop " << this << " stop looping";

looping_ = false;

}

|

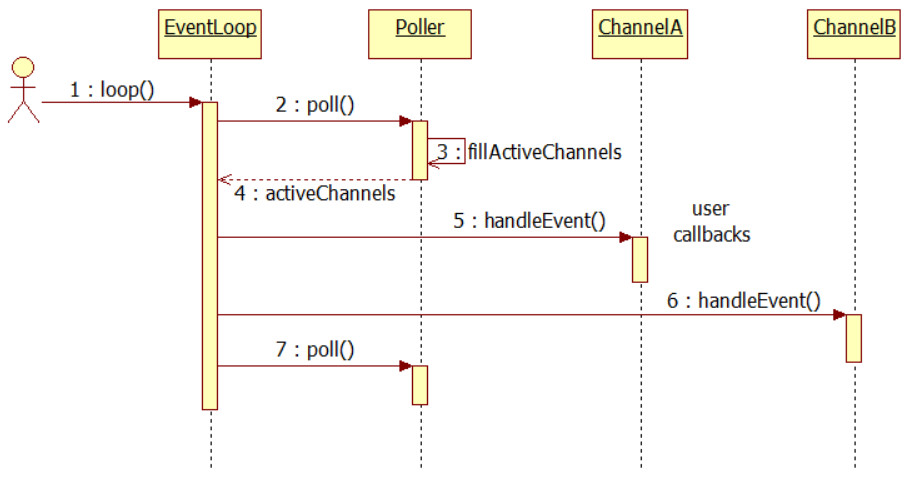

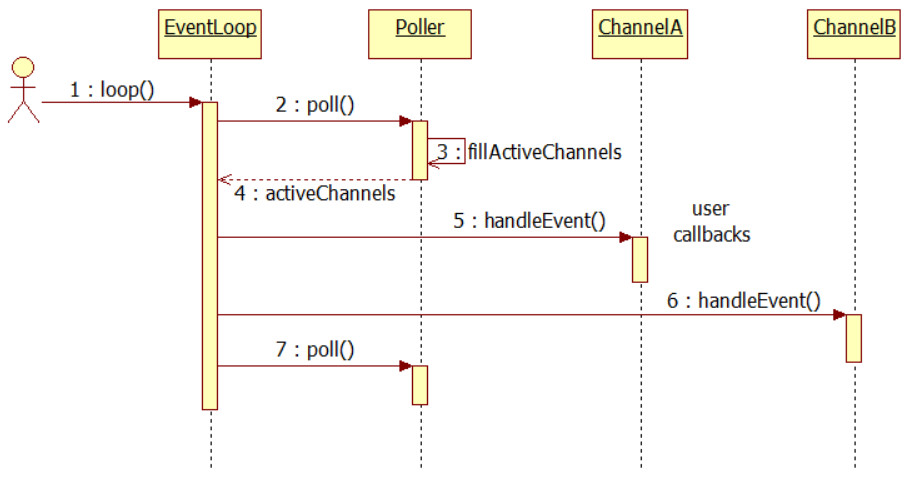

该函数通过调用Poller的poll函数,将活跃Channel保存到activeChannels_中,然后遍历这些Channel,执行它们的handleEvent函数,最后执行doPendingFunctors函数,该函数将在下一节介绍。

14.4 跨线程执行函数

为了实现跨线程调用函数,muduo使用了如下数据结构:

1

2

3

4

5

6

|

bool callingPendingFunctors_; //判断是否IO线程处理一些回调任务中=>pendingFunctors_

int wakeupFd_; // 用于eventfd

// unlike in TimerQueue, which is an internal class,

// we don't expose Channel to client.

boost::scoped_ptr<Channel> wakeupChannel_; // 该通道将会纳入poller_来管理

std::vector<Functor> pendingFunctors_; // @BuardedBy mutex_ 即将发生的回调,即在IO线程中执行需要执行回调函数集合

|

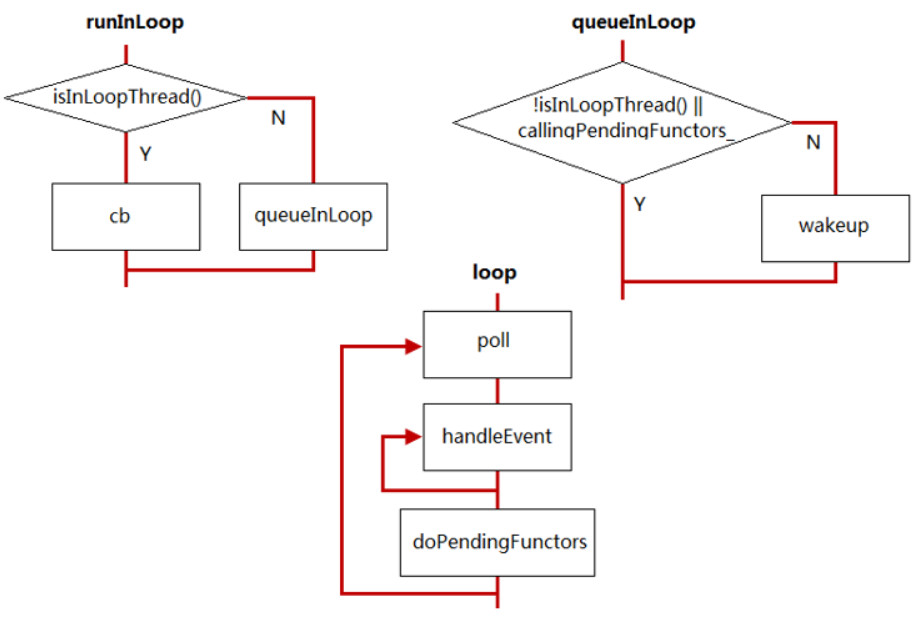

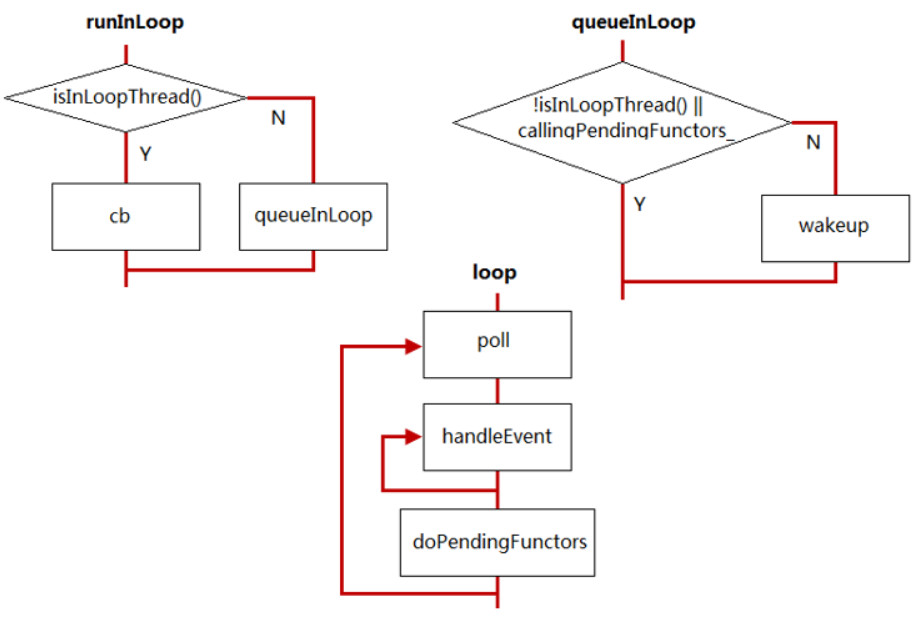

TimerQueue的更新和删除Timer会用到EventLoop::runInLoop函数,该函数的实现如下:

1

2

3

4

5

6

7

8

9

10

|

// 在I/O线程中执行某个回调函数,该函数可以跨线程调用

void EventLoop::runInLoop(const Functor &cb) {

if (isInLoopThread()) {

// 如果是当前IO线程调用runInLoop,则同步调用cb

cb();

} else {

// 如果是其它线程调用runInLoop,则异步地将cb添加到队列,以便让EventLoop所在的线程执行这个回调函数

queueInLoop(cb);

}

}

|

以更新Timer为例:

1

|

loop_->runInLoop(boost::bind(&TimerQueue::addTimerInLoop, this, timer));

|

如果该代码时是在EventLoop所在线程中执行,那么TimerQueue::addTimerInLoop会立刻执行,否则TimerQueue::addTimerInLoop将通过queueInLoop函数送入到待执行函数队列中,queueInLoop定义如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

|

void EventLoop::queueInLoop(const Functor &cb) {

{

MutexLockGuard lock(mutex_);

pendingFunctors_.push_back(cb);

}

/**

* 1. 调用queueInLoop的线程不是IO线程需要唤醒

* 2. 或者调用queueInLoop的线程是IO线程,并且此时正在调用任务队列(pendingFunctors_),需要唤醒。

* =》 因为I/O处于callingPendingFunctors_状态,任务队列(pendingFunctors_)中的任务执行完可能会处于阻塞状态(poll没事件发生),新加入的任务无法执行。

*

* 只有I/O线程的事件回调中调用queueInLoop才不需要唤醒

*/

if (!isInLoopThread() || callingPendingFunctors_) {

wakeup();

}

}

|

该函数会判断是否是在EventLoop所处线程中执行,如果不是的话则调用wakeup()函数。

先解释下跨线程调用的原理:一个EventLoop中有一个wakeupFd_文件描述符(eventfd 是一个比 pipe 更高效的线程间事件通知机制,一方面它比 pipe 少用一个 file descripor,节省了资源;另一方面,eventfd 的缓冲区管理也简单得多,全部"buffer" 只有定长8 bytes,不像 pipe 那样可能有不定长的真正 buffer),该文件描述符在构造函数初始化列表中完成初始化:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

int createEventfd() {

int evtfd = ::eventfd(0, EFD_NONBLOCK | EFD_CLOEXEC);

if (evtfd < 0) {

LOG_SYSERR << "Failed in eventfd";

abort();

}

return evtfd;

}

EventLoop::EventLoop()

: looping_(false),

...

wakeupFd_(createEventfd()),

... {

...

}

|

而且EventLoop也为该wakeuFd_文件描述符提供了一个Channel,该Channel的生命周期由EventLoop对象负责:

1

|

boost::scoped_ptr<Channel> wakeupChannel_;

|

该Channel也在构造函数中完成了初始化工作:

1

2

3

4

5

6

7

8

9

10

11

12

13

|

EventLoop::EventLoop()

: looping_(false),

...

wakeupFd_(createEventfd()),

wakeupChannel_(new Channel(this, wakeupFd_)),

... {

...

wakeupChannel_->setReadCallback(

boost::bind(&EventLoop::handleRead, this));

// we are always reading the wakeupfd

//这里设置会将wakeupChannel_注册到Poller对象中,实现事件循环

wakeupChannel_->enableReading();

}

|

该Channel也加入到了Poller事件监听中,并且设置了"读事件"回调函数为EventLoop::handleRead:

1

2

3

4

5

6

7

8

|

// eventfd 事件处理函数

void EventLoop::handleRead() {

uint64_t one = 1;

ssize_t n = sockets::read(wakeupFd_, &one, sizeof one);

if (n != sizeof one) {

LOG_ERROR << "EventLoop::handleRead() reads " << n << " bytes instead of 8";

}

}

|

现在回到queueInLoop函数中,可以正式介绍wake()函数了,wakeup函数功能就是向wakeupFd_写入东西,然后促使Poller的poll函数返回:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

// 唤醒,写uint64_t类型的字节就可产生可读事件,达到唤醒的目的

void EventLoop::wakeup() {

uint64_t one = 1;

// ssize_t n = sockets::write(wakeupFd_, &one, sizeof one);

ssize_t n = ::write(wakeupFd_, &one, sizeof one);

if (n != sizeof one) {

LOG_ERROR << "EventLoop::wakeup() writes " << n << " bytes instead of 8";

}

}

void EventLoop::loop() {

...

while (!quit_)

{

activeChannels_.clear();

pollReturnTime_ = poller_->poll(kPollTimeMs, &activeChannels_);

...

doPendingFunctors();

}

...

}

|

然后进而调用doPendingFunctors函数,在该函数中执行这些跨线程调用的"未决函数":

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

//在IO线程中执行一些回调任务

void EventLoop::doPendingFunctors() {

std::vector<Functor> functors;

callingPendingFunctors_ = true;

{

MutexLockGuard lock(mutex_);

//可以减小临界区的长度(意味着不会阻塞其它线程的queueInLoop()),另一方面,也避免了死锁(因为Functor可能再次调用queueInLoop())

functors.swap(pendingFunctors_);

}

for (size_t i = 0; i < functors.size(); ++i) {

functors[i]();

}

callingPendingFunctors_ = false;

}

|

这样即使是跨线程调用某些函数,这些函数也不会立刻执行,而是存入该pendingFunctors_集合中等待wake,然后在EventLoop线程中"打包"执行。

需要注意的是:

- 不是简单地在临界区内依次调用Functor,而是把回调列表swap到functors中,这样一方面减小了临界区的长度(意味着不会阻塞其它线程的queueInLoop()),另一方面,也避免了死锁(因为Functor可能再次调用queueInLoop())

- 由于doPendingFunctors()调用的Functor可能再次调用queueInLoop(cb),这时,queueInLoop()就必须wakeup(),否则新增的cb可能就不能及时调用了

- muduo没有反复执行doPendingFunctors()直到pendingFunctors为空,这是有意的,否则IO线程可能陷入死循环,无法处理IO事件。

14.5 析构函数与资源销毁

整个EventLoop中创建了如下资源:

1

2

3

4

5

6

7

8

9

10

|

EventLoop::EventLoop()

: looping_(false),

...

poller_(Poller::newDefaultPoller(this)),

timerQueue_(new TimerQueue(this)),

wakeupFd_(createEventfd()),

wakeupChannel_(new Channel(this, wakeupFd_)),

... {

...

}

|

然而这些资源除了wakeupFd_以外都是使用智能指针来管理的:

1

2

3

4

5

6

|

boost::scoped_ptr<Poller> poller_;

boost::scoped_ptr<TimerQueue> timerQueue_;

int wakeupFd_; // 用于eventfd

// unlike in TimerQueue, which is an internal class,

// we don't expose Channel to client.

boost::scoped_ptr<Channel> wakeupChannel_; // 该通道将会纳入poller_来管理

|

所以析构函数只需要释放wakeupFd_文件描述符即可:

1

2

3

4

5

6

7

|

EventLoop::~EventLoop() {

//析构,EventLoop对象一定不会是looping状态

assert(!looping_);

::close(wakeupFd_);

t_loopInThisThread = nullptr;

}

|

15. muduo 事件监听总结

15.1 Channel及其文件描述符如何加入到Poller中

15.2 EventLoop如何获取活跃的Channel并处理相关事件

15.3 EventLoop如何处理定时器

15.4 EventLoop与跨线程调用函数

- 调用queueInLoop的线程不是当前IO线程需要唤醒

- 或者调用queueInLoop的线程是当前IO线程,并且此时正在调用pending functor,需要唤醒

- 只有IO线程的事件回调中调用queueInLoop才不需要唤醒

16. EventLoopThread

任何一个线程,只要创建并运行了EventLoop,都称之为IO线程,所以IO线程不一定是主线程。

muduo并发模型one loop per thread + threadpool,为了方便今后使用,定义了EventLoopThread类,该类封装了IO线程。EventLoopThread创建了一个线程,然后在线程函数中创建了一个EvenLoop对象并调用EventLoop::loop。

由于该EventLoopThread类会在一个线程中启动一个EventLoop,所以持有如下变量:

1

2

|

EventLoop* loop_;

Thread thread_;

|

构造函数:

1

2

3

4

5

6

7

8

9

|

EventLoopThread::EventLoopThread(const ThreadInitCallback& cb)

: loop_(NULL),

exiting_(false),

thread_(boost::bind(&EventLoopThread::threadFunc, this)),

mutex_(),

cond_(mutex_),

callback_(cb) {

}

|

从构造函数中可以看出,该EventLoop默认是没有初始化的,线程绑定的执行函数是EventLoopThread::threadFunc。除此之外,构造函数中还初始化了互斥锁和条件变量,它们作用会在后面分析。

构造函数中还传入了一个ThreadInitCallback类型的函数对象:

1

2

3

|

typedef boost::function<void(EventLoop*)> ThreadInitCallback;

ThreadInitCallback callback_;

|

这是用作线程启动初始化执行的用户函数,如果用户想在线程初始化时执行一些函数,那么就可以在EventLoopThread构造函数中传入该函数,默认情况下EventLoopThread会创建一个空函数作为线程初始化函数:

1

|

EventLoopThread(const ThreadInitCallback &cb = ThreadInitCallback());

|

那么,如何启动一个IO线程呢?使用EventLoopThread::startLoop便可以"启动"一个IO线程,这里的"启动"指的是启动IO线程,而不是线程,因为构造函数在已经初始化一个线程了,光启动该线程还不能称为"IO线程",因为EventLoop还没有初始化,EventLoopThread::startLoop会通过条件变量一直等待,直到EventLoop被初始化,条件满足时才返回该EventLoop地址:

1

2

3

4

5

6

7

8

9

10

11

12

13

|

EventLoop *EventLoopThread::startLoop() {

assert(!thread_.started());

thread_.start();

{

MutexLockGuard lock(mutex_);

while (loop_ == NULL) {

cond_.wait();

}

}

return loop_;

}

|

那么EventLoop在哪里初始化,条件变量又如何被通知呢?这些问题都在线程执行函数中完成:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

|

void EventLoopThread::threadFunc() {

EventLoop loop;

// 线程初始化函数

if (callback_) {

callback_(&loop);

}

{

MutexLockGuard lock(mutex_);

// loop_指针指向了一个栈上的对象,threadFunc函数退出之后,这个指针就失效了

// threadFunc函数退出,就意味着线程退出了,EventLoopThread对象也就没有存在的价值了。

// 因而不会有什么大的问题

loop_ = &loop;

cond_.notify();

}

loop.loop();

// assert(exiting_);

}

|

当EventLoopThread类创建后,会在构造函数阶段创建一个线程,而该线程便执行threadFunc函数,如果用户传入了"线程初始化函数",那么在这里便会优先执行该函数,然后初始化所持有的EventLoop,并发让条件满足(loop_!=NULL),然后启动EventLoop的事件循环(loop.loop())。

这一过程下来,当一个EventLoopThread 被创建后,该EventLoopThread 对象内部也创建并启动了一个EventLoop对象,用户代码需要startLoop函数来获取该EventLoop对象,然后让该EventLoop中的Poller对象和一些Channel绑定,让Channel中的文件描述符加入事件监听中。所以该EventLoop可以在其他线程里被调用,这就是为什么EventLoop中还提供了runInLoop函数的原因,也为后续的EventLoopThreadPool做出铺垫。

调用startLoop函数一定会发生在两个线程中,例如:main线程调用startLoop函数,那么startLoop内部会创建一个线程(可以理解为I/O线程),startLoop函数返回EventLoop对象到调用线程main,该EventLoop对象一定是I/O线程创建的对象。

最后的析构函数则做了些收尾工作:

1

2

3

4

5

|

EventLoopThread::~EventLoopThread() {

exiting_ = true;

loop_->quit(); // 退出IO线程,让IO线程的loop循环退出,从而退出了IO线程

thread_.join();

}

|

下面是一个简单的使用案例,可以帮助理解EventLoopThread的使用:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

|

#include "EventLoop.h"

#include "EventLoopThread.h"

#include <stdio.h>

using namespace muduo;

using namespace muduo::net;

void runInThread() {

printf("runInThread(): pid = %d, tid = %d\n", getpid(), CurrentThread::tid());

}

void threadInitFC(EventLoop *loop) {

printf("threadInitFC(): pid = %d, tid = %d\n", getpid(),

CurrentThread::tid());

}

int main() {

printf("main(): pid = %d, tid = %d\n", getpid(), CurrentThread::tid());

EventLoopThread loopThread(threadInitFC);

EventLoop *loop = loopThread.startLoop();

// 异步调用runInThread,即将runInThread添加到loop对象所在IO线程,让该IO线程执行

loop->runInLoop(runInThread);

sleep(1);

// runAfter内部也调用了runInLoop,所以这里也是异步调用

loop->runAfter(2, runInThread);

sleep(3);

loop->quit();

printf("exit main().\n");

return 0;

}

|

17. EventLoopThreadPool

该类的作用就是"事先缓存多个EventLoopThread",所以该类中需要有保存这些EventLoopThread及其EventLoop的数据结构:

1

2

|

boost::ptr_vector<EventLoopThread> threads_; // IO线程列表

std::vector<EventLoop *> loops_; // EventLoop列表

|

通过setThreadNum函数来设置需要创建多少个IO线程(创建后的调整):

1

|

void setThreadNum(int numThreads) { numThreads_ = numThreads; }

|

如果用户传入数量为0(默认构造函数中设置为0),那么该EventLoopThreadPool就会作为IO线程,EventLoopThreadPool内的baseLoop_持有这个EventLoop对象:

1

2

3

4

5

6

7

|

EventLoopThreadPool::EventLoopThreadPool(EventLoop* baseLoop)

: baseLoop_(baseLoop),

started_(false),

numThreads_(0),

next_(0) {

}

|

调用EventLoopThreadPool::start函数创建numThreads_个EventLoopThread。如果numThreads_为0且有线程初始化函数需要执行,那么就在EventLoopThreadPool所处线程中执行该函数。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

|

void EventLoopThreadPool::start(const ThreadInitCallback &cb) {

assert(!started_);

baseLoop_->assertInLoopThread();

started_ = true;

for (int i = 0; i < numThreads_; ++i) {

EventLoopThread *t = new EventLoopThread(cb);

threads_.push_back(t);

loops_.push_back(

t->startLoop()); // 启动EventLoopThread线程,在进入事件循环之前,会调用cb

}

if (numThreads_ == 0 && cb) {

// 只有一个EventLoop,在这个EventLoop进入事件循环之前,调用cb

cb(baseLoop_);

}

}

|

考虑到负载均衡,该类还实现了一个基于轮询方法来选择要使用的EventLoop(IO线程):

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

|

EventLoop *EventLoopThreadPool::getNextLoop() {

baseLoop_->assertInLoopThread();

EventLoop *loop = baseLoop_;

// 如果loops_为空(即numThreads_为0),则loop指向baseLoop_

// 如果不为空,按照round-robin(RR,轮叫)的调度方式选择一个EventLoop

if (!loops_.empty()) {

// round-robin

loop = loops_[next_];

++next_;

if (implicit_cast<size_t>(next_) >= loops_.size()) {

next_ = 0;

}

}

return loop;

}

|

18. 网络套接字相关

18.1 Endian

Endian.h头文件封装了字节序转换函数(全局函数,位于muduo::net::sockets名称空间中)。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

|

#ifndef MUDUO_NET_ENDIAN_H

#define MUDUO_NET_ENDIAN_H

#include <endian.h>

#include <stdint.h>

namespace muduo {

namespace net {

namespace sockets {

// the inline assembler code makes type blur,

// so we disable warnings for a while.

#if __GNUC_MINOR__ >= 6

#pragma GCC diagnostic push

#endif

#pragma GCC diagnostic ignored "-Wconversion"

#pragma GCC diagnostic ignored "-Wold-style-cast"

// posix标准

// 主机字节序转换成网络字节序

inline uint64_t hostToNetwork64(uint64_t host64) { return htobe64(host64); }

inline uint32_t hostToNetwork32(uint32_t host32) { return htobe32(host32); }

inline uint16_t hostToNetwork16(uint16_t host16) { return htobe16(host16); }

// 网络字节序转换成主机字节序

inline uint64_t networkToHost64(uint64_t net64) { return be64toh(net64); }

inline uint32_t networkToHost32(uint32_t net32) { return be32toh(net32); }

inline uint16_t networkToHost16(uint16_t net16) { return be16toh(net16); }

#if __GNUC_MINOR__ >= 6

#pragma GCC diagnostic pop

#else

#pragma GCC diagnostic error "-Wconversion"

#pragma GCC diagnostic error "-Wold-style-cast"

#endif

} // namespace sockets

} // namespace net

} // namespace muduo

#endif // MUDUO_NET_ENDIAN_H

|

18.2 SocketsOps

18.2.1 补充知识

下面是几个被封装的函数原型:

1

2

3

4

5

6

|

#include <arpe/inet.h>

//将点分十进制的ip地址转化为用于网络传输的数值格式 返回值:若成功则为1,若输入不是有效的表达式则为0,若出错则为-1

int inet_pton(int family, const char *strptr, void *addrptr);

//将数值格式转化为点分十进制的ip地址格式返回值:若成功则为指向结构的指针,若出错则为NULL

const char * inet_ntop(int family, const void *addrptr, char *strptr, size_t len);

|

- 这两个函数的family参数既可以是AF_INET(ipv4)也可以是AF_INET6(ipv6)。如果,以不被支持的地址族作为family参数,这两个函数都返回一个错误,并将errno置为EAFNOSUPPORT.

- 第一个函数尝试转换由strptr指针所指向的字符串,并通过addrptr指针存放二进制结果,若成功则返回值为1,否则如果所指定的family而言输入字符串不是有效的表达式格式,那么返回值为0.

- inet_ntop进行相反的转换,从数值格式(addrptr)转换到表达式(strptr)。inet_ntop函数的strptr参数不可以是一个空指针。调用者必须为目标存储单元分配内存并指定其大小,调用成功时,这个指针就是该函数的返回值。len参数是目标存储单元的大小,以免该函数溢出其调用者的缓冲区。如果len太小,不足以容纳表达式结果,那么返回一个空指针,并置为errno为ENOSPC。

1

2

3

|

#include<sys/socket.h>

int getsockname(int sockfd, struct sockaddr *localaddr, socklen_t *addrlen); //用于获取与某个套接字关联的本地协议地址

int getpeername(int sockfd, struct sockaddr *peeraddr, socklen_t *addrlen); //用于获取与某个套接字关联的外地协议地址

|

对于这两个函数,如果函数调用成功,则返回0,如果调用出错,则返回-1。使用这两个函数,我们可以通过套接字描述符来获取自己的IP地址和连接对端的IP地址,如在未调用bind函数的TCP客户端程序上,可以通过调用getsockname()函数获取由内核赋予该连接的本地IP地址和本地端口号,还可以在TCP的服务器端accept成功后,通过getpeername()函数来获取当前连接的客户端的IP地址和端口号。

18.2.2 源码分析

该类封装了socket相关系统调用(全局函数,位于muduo::net::sockets名称空间中)。它提供了众多对socket套接字操作的函数,各个函数之间也很少互相调用,基本就是将网络套接字API封装了一遍:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

|

#ifndef MUDUO_NET_SOCKETSOPS_H

#define MUDUO_NET_SOCKETSOPS_H

#include <arpa/inet.h>

namespace muduo {

namespace net {

namespace sockets {

///

/// Creates a non-blocking socket file descriptor,

/// abort if any error.

// 创建一个非阻塞套接字,如果创建失败就终止程序abort

int createNonblockingOrDie();

int connect(int sockfd, const struct sockaddr_in &addr);

void bindOrDie(int sockfd, const struct sockaddr_in &addr);

void listenOrDie(int sockfd);

int accept(int sockfd, struct sockaddr_in *addr);

ssize_t read(int sockfd, void *buf, size_t count);

ssize_t readv(int sockfd, const struct iovec *iov, int iovcnt);

ssize_t write(int sockfd, const void *buf, size_t count);

void close(int sockfd);

void shutdownWrite(int sockfd);

void toIpPort(char *buf, size_t size, const struct sockaddr_in &addr);

void toIp(char *buf, size_t size, const struct sockaddr_in &addr);

void fromIpPort(const char *ip, uint16_t port, struct sockaddr_in *addr);

int getSocketError(int sockfd);

struct sockaddr_in getLocalAddr(int sockfd);

struct sockaddr_in getPeerAddr(int sockfd);

bool isSelfConnect(int sockfd);

} // namespace sockets

} // namespace net

} // namespace muduo

#endif // MUDUO_NET_SOCKETSOPS_H

|

接下来分析这些定义的函数源码,首先将sockaddr定义为了SA类型:

1

|

typedef struct sockaddr SA; //通用地址

|

下面这两个函数将sockaddr_in类型转换为sockaddr类型:

1

2

3

4

5

6

7

8

|

// 网际地址转换通用地址

const SA *sockaddr_cast(const struct sockaddr_in *addr) {

return static_cast<const SA *>(implicit_cast<const void *>(addr));

}

SA *sockaddr_cast(struct sockaddr_in *addr) {

return static_cast<SA *>(implicit_cast<void *>(addr));

}

|

下面这个函数设置套接字文件描述符为非阻塞close-on-exec,意思是调用套接字的进程如果创建了子进程,那么子进程将自动关闭这个拷贝的文件描述符,该文件的状态就不会带到子进程中。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

void setNonBlockAndCloseOnExec(int sockfd) {

// non-block

int flags = ::fcntl(sockfd, F_GETFL, 0);

flags |= O_NONBLOCK;

int ret = ::fcntl(sockfd, F_SETFL, flags);

// FIXME check

// close-on-exec

flags = ::fcntl(sockfd, F_GETFD, 0);

flags |= FD_CLOEXEC;

ret = ::fcntl(sockfd, F_SETFD, flags);

// FIXME check

(void)ret;

}

|

浅析open函数O_CLOEXEC模式和fcntl函数FD_CLOEXEC选项

接下来这个函数只是调用了socket函数返回一个文件描述符,同时也做了错误判断:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

|

int sockets::createNonblockingOrDie() {

// socket

#if VALGRIND // 内存泄露检测工具,还能够检测文件描述符的打开状态

int sockfd = ::socket(AF_INET, SOCK_STREAM, IPPROTO_TCP);

if (sockfd < 0) {

LOG_SYSFATAL << "sockets::createNonblockingOrDie";

}

setNonBlockAndCloseOnExec(sockfd);

#else

// Linux 2.6.27以上的内核支持SOCK_NONBLOCK与SOCK_CLOEXEC

int sockfd = ::socket(AF_INET, SOCK_STREAM | SOCK_NONBLOCK | SOCK_CLOEXEC,

IPPROTO_TCP);

if (sockfd < 0) {

LOG_SYSFATAL << "sockets::createNonblockingOrDie";

}

#endif

return sockfd;

}

|

下面这两个函数分别绑定和监听了一个套接字:

1

2

3

4

5

6

7

8

9

10

11

12

13

|

void sockets::bindOrDie(int sockfd, const struct sockaddr_in &addr) {

int ret = ::bind(sockfd, sockaddr_cast(&addr), sizeof addr);

if (ret < 0) {

LOG_SYSFATAL << "sockets::bindOrDie";

}

}

void sockets::listenOrDie(int sockfd) {

int ret = ::listen(sockfd, SOMAXCONN);

if (ret < 0) {

LOG_SYSFATAL << "sockets::listenOrDie";

}

}

|

下面这个函数接受一个连接,如果出错则会判断错误类型,如果错误是预期错误(expected errors),则直接退出,否则写入日志:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

|

int sockets::accept(int sockfd, struct sockaddr_in *addr) {

socklen_t addrlen = sizeof *addr;

#if VALGRIND

int connfd = ::accept(sockfd, sockaddr_cast(addr), &addrlen);

setNonBlockAndCloseOnExec(connfd);

#else

int connfd = ::accept4(sockfd, sockaddr_cast(addr), &addrlen,

SOCK_NONBLOCK | SOCK_CLOEXEC);

#endif

if (connfd < 0) {

// 系统调用或者库函数可能会改变errno的值,所以先保存下来

int savedErrno = errno;

LOG_SYSERR << "Socket::accept";

switch (savedErrno) {

case EAGAIN:

case ECONNABORTED:

case EINTR:

case EPROTO: // ???

case EPERM:

case EMFILE: // per-process lmit of open file desctiptor ???

// expected errors

errno = savedErrno;

break;

case EBADF:

case EFAULT:

case EINVAL:

case ENFILE:

case ENOBUFS:

case ENOMEM:

case ENOTSOCK:

case EOPNOTSUPP:

// unexpected errors

LOG_FATAL << "unexpected error of ::accept " << savedErrno;

break;

default:

LOG_FATAL << "unknown error of ::accept " << savedErrno;

break;

}

}

return connfd;

}

|

下面这些函数都是对socket相关函数的简单封装:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

|

int sockets::connect(int sockfd, const struct sockaddr_in &addr) {

return ::connect(sockfd, sockaddr_cast(&addr), sizeof addr);

}

ssize_t sockets::read(int sockfd, void *buf, size_t count) {

return ::read(sockfd, buf, count);

}

// readv与read不同之处在于,接收的数据可以填充到多个缓冲区中

// iov 可以是一个缓冲区数组,第一个缓冲区写满就接着写第二个缓冲区

ssize_t sockets::readv(int sockfd, const struct iovec *iov, int iovcnt) {

return ::readv(sockfd, iov, iovcnt);

}

ssize_t sockets::write(int sockfd, const void *buf, size_t count) {

return ::write(sockfd, buf, count);

}

void sockets::close(int sockfd) {

if (::close(sockfd) < 0) {

LOG_SYSERR << "sockets::close";

}

}

|

下面这个函数关闭传入套接字的写端:

1

2

3

4

5

6

|

// 只关闭写的这一半,进入半关闭状态(close SHUT_WR)

void sockets::shutdownWrite(int sockfd) {

if (::shutdown(sockfd, SHUT_WR) < 0) {

LOG_SYSERR << "sockets::shutdownWrite";

}

}

|

接下来是几个地址转换函数,网络传输地址与本地点分十进制地址转换:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

|

// 主要调用toIP函数,将sockaddr_in.sin_addr 转换成ip和端口的形式保存到buf当中

void sockets::toIpPort(char *buf, size_t size, const struct sockaddr_in &addr) {

char host[INET_ADDRSTRLEN] = "INVALID";

toIp(host, sizeof host, addr);

// 网络端口转换成主机字节序端口

uint16_t port = sockets::networkToHost16(addr.sin_port);

snprintf(buf, size, "%s:%u", host, port);

}

// 转换ip

void sockets::toIp(char *buf, size_t size, const struct sockaddr_in &addr) {

assert(size >= INET_ADDRSTRLEN);

// 转换成点分十进制的形式

::inet_ntop(AF_INET, &addr.sin_addr, buf, static_cast<socklen_t>(size));

}

// 与上面两个函数相反,将点分十进制ip转换为一个sockaddr_in.sin_addr

void sockets::fromIpPort(const char *ip, uint16_t port,

struct sockaddr_in *addr) {

addr->sin_family = AF_INET;

addr->sin_port = hostToNetwork16(port);

if (::inet_pton(AF_INET, ip, &addr->sin_addr) <= 0) {

LOG_SYSERR << "sockets::fromIpPort";

}

}

|

下面这个函数获取错误状况:

1

2

3

4

5

6

7

8

9

10

|

int sockets::getSocketError(int sockfd) {

int optval;

socklen_t optlen = sizeof optval;

if (::getsockopt(sockfd, SOL_SOCKET, SO_ERROR, &optval, &optlen) < 0) {

return errno;

} else {

return optval;

}

}

|

下面这两个函数分别获取本地地址和连接客户端地址信息:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

// 本地地址

struct sockaddr_in sockets::getLocalAddr(int sockfd) {

struct sockaddr_in localaddr;

bzero(&localaddr, sizeof localaddr);

socklen_t addrlen = sizeof(localaddr);

if (::getsockname(sockfd, sockaddr_cast(&localaddr), &addrlen) < 0) {

LOG_SYSERR << "sockets::getLocalAddr";

}

return localaddr;

}

// 对等端地址

struct sockaddr_in sockets::getPeerAddr(int sockfd) {

struct sockaddr_in peeraddr;

bzero(&peeraddr, sizeof peeraddr);

socklen_t addrlen = sizeof(peeraddr);

if (::getpeername(sockfd, sockaddr_cast(&peeraddr), &addrlen) < 0) {

LOG_SYSERR << "sockets::getPeerAddr";

}

return peeraddr;

}

|

最后防止自连接:

1

2

3

4

5

6

|

bool sockets::isSelfConnect(int sockfd) {

struct sockaddr_in localaddr = getLocalAddr(sockfd);

struct sockaddr_in peeraddr = getPeerAddr(sockfd);

return localaddr.sin_port == peeraddr.sin_port &&

localaddr.sin_addr.s_addr == peeraddr.sin_addr.s_addr;

}

|

自连接是指(sourceIP, sourcePort) == (destIP, destPort)。

自连接发生的原因:

- 客户端在发起connect的时候,没有bind(2)

- 客户端与服务器端在同一台机器,即sourceIP = destIP,

- 服务器尚未开启,即服务器还没有在destPort端口上处于监听

这些情况就有可能出现自连接,这样,服务器也无法启动了。

18.3 InetAddress

该类主要提供了一些地址转换的函数(例如从网络字节序到本地字节序),调用了SocketsOps里的地址函数。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

|

#ifndef MUDUO_NET_INETADDRESS_H

#define MUDUO_NET_INETADDRESS_H

#include "StringPiece.h"

#include "copyable.h"

#include <netinet/in.h>

namespace muduo {

namespace net {

///

/// Wrapper of sockaddr_in.

///

/// This is an POD interface class.

class InetAddress : public muduo::copyable {

public:

/// Constructs an endpoint with given port number.